거대언어모델은 GPU로 대표되는 컴퓨팅 파워를 필요로 하는 두 가지 시기를 가지고 있다. 첫 번째 시기는 일반적으로 모델 학습이라고 알려진 모델 구축 시기다. 이 기간동안 대량의 데이터를 처리하여 거대언어모델 내부 토큰-단어 또는 단어 덩어리- 구조가 만들어진다. 이 토큰 구조는 거대언어모델이 언어의 패턴과 상관관계를 인식하고 언어를 생성할 수 있는 기반을 형성한다. 두 번째 시기는 소위 추론(inference) 단계다. o1의 의미를 이해하기 위해 추론이라 불리는 인퍼런스(inference)와 추리로 해석할 수 있는 리즈닝(reasoning)의 차이를 구별할 필요가 있다. 인퍼런스는 거대언어모델이 학습 중에 구축된 내부 구조를 적용하여 이용자 입력에 대한 출력을 생성하는 실행과정을 의미한다. 바로 결과물을 도출하는 순간이다. 지금까지 인퍼런스에서 중요한 것은 이용자 입력에 빠르게 반응하는 속도와 실행과정에서 가능하다면 컴퓨팅 파워를 적게 쓰는 자원 효율성이다. 리즈닝은 거대언어모델이 논리적이고 단계적인 사고 과정을 통해 복잡한 문제를 해결하는 능력을 의미한다. 인퍼런스와 달리 리즈닝에서 중요한 것은 결과물의 품질과 정확성이다. 지금까지 거대언어모델은 리즈닝보다 인퍼런스에 더 집중하고 있었고 o1은 리즈닝에 더 높은 가치를 부여하고 있다. 이러한 관점에서 o1은 지금까지 거대언어모델 발전 경로에서 명확한 단절을 의미한다.

전통 거대언어모델: 모델 학습은 비싸고, 추론은 저렴

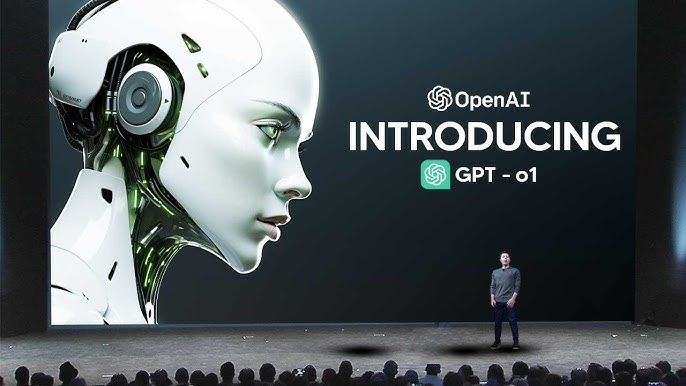

인퍼런스에서 리즈닝으로 무게 중심을 옮긴 것이 첫 번째 단절이라면, 기술 투자의 무게 중심이 모델 학습에서 인퍼런스와 리즈닝을 포함한 추론 단계로 옮겨간 것이 두 번째 단절이다. 전통 산업과 비교하자면, 모델 학습 단계는 새로운 생산 시설을 갖춘 공장을 설계하고 건설하는 것과 같다. 추론은 공장을 성공적으로 세팅한 이후 이 공장에서 이루어지는 생산, 다시말해 생산 시설의 실제 활용을 의민하다. 지금까지 거대언어모델을 개선 및 발전시킬 때 모델 훈련 단계에 집중해 왔다. 언어모델이 대형화됨에 따라 이 단계는 수년에 걸쳐 더 길어지고 그 비용이 크게 증가했다. 더 많은 매개 변수(parameters), 다시말해 언어모델이 학습하는 동안 배우는 변수(variables)가 많으면 많을 수록 학습 비용은 증가하지만 일반적으로 더 나은 성능의 모델을 만들 수 있다. 모델 훈련 비용에 대한 공식적인 수치는 없다. 전문가들은 클로드(Claude) 3.5의 훈련 비용이 1억에서 2억 달러에 달할 것으로 추정하고 있다. 스탠포드 대학교 AI 인덱스 보고서에 따르면 GPT-4의 학습 비용은 약 7,800만 달러, 제미나이 울트라의 경우 1억 9,100만 달러가 모델 학습에 들어갔다. 클로드 개발기업인 앤트로픽(Anthropic)의 대표 다리오 아모데이(Dario Amodei)는 2025년 또는 2026년 거대언어모델당 학습 비용이 최대 100억 달러까지 상승할 수 있다고 예측하고 있다. 다리오 아모데이의 예측이 사실인지 아니면 새로운 경쟁자가 거대언어모델을 학습시키는 것을 막기 위해서 공포감을 조성하려는 것인지 아직 밝혀지지 않았다. 그러나 학습 비용 상승 추세는 분명하다. 가장 크고 일반적으로 가장 우수한 모델이 점점 더 커지고 있으며, 따라서 학습 비용이 함께 증가하고 있다. 증가하는 학습 비용은 언어모델 제공 기업이 부담하며, 모델마다 규모가 커짐에 따라 높은 학습 비용은 점점 더 시장 진입 장벽이 되고 있다. 모델 학습에 1억 달러 이상을 투자할 수 있는 기업은 소수에 불과하기 때문이다. 높은 학습 비용외에도 희소성 있는 컴퓨팅 성능과 그에 못지않게 부족한 숙련된 AI 인재도 시장 진입장벽이다.

![[자료] '제로 클릭' AI 검색이 뉴스 비즈니스에 미치는 영향과 대안](https://cdn.media.bluedot.so/bluedot.thecore/2025/11/ivacbx_202511130202.png)

![[발표자료] GEO시대, 미디어채널 재설계 전략

- AI가 답하는 세상, 당신의 브랜드는 준비되었나요?](https://cdn.media.bluedot.so/bluedot.thecore/2025/09/povk3t_202509261048.jpg)

![[자료] AI 시대, 해외언론사들의 AI 도입 현황과 전략](https://cdn.media.bluedot.so/bluedot.thecore/2025/09/aqzesl_202509220109.10.png)

![[자료] AI 기반의 팩트체킹 방법론](https://cdn.media.bluedot.so/bluedot.thecore/2025/09/ebjijm_202509220114.18.png)

![[자료] AI 검색과 PR & 브랜드 마케팅의 대전환](https://cdn.media.bluedot.so/bluedot.thecore/2025/04/el4rkl_202504220930.25.png)

![[특강자료] PR 업무 현장에서의 AI 활용방안](https://cdn.media.bluedot.so/bluedot.thecore/2024/10/lwzhek_202410220533.JPG)

![[자료] 기자와 언론사를 위한 생성AI 활용 방안](https://cdn.media.bluedot.so/bluedot.thecore/2025/03/r69w3p_202503180637.00.png)